IA générative : comprendre avant qu’elle nous dépasse

L’intelligence artificielle générative fascine autant qu’elle inquiète. Contrairement aux logiciels traditionnels, ses modèles d’IA produisent des résultats complexes sans que leurs créateurs comprennent totalement leur fonctionnement. Cette opacité soulève des enjeux majeurs de sécurité, notamment à l’approche de systèmes d’IA ultra-puissants.

Dario Amodei, cofondateur d’Anthropic, alerte sur ce « défaut de compréhension inédit dans l’histoire technologique ». La discipline émergente de l’interprétabilité de l’IA (ou mechanistic interpretability) cherche à analyser les processus internes des grands modèles de langage comme ChatGPT ou Gemini. L’objectif est d’identifier les biais, corriger les erreurs et prévenir les dérives.

Des chercheurs comme Chris Olah, Neel Nanda (chez DeepMind) ou Anh Nguyen (Université d’Auburn) comparent cette quête à celle des neurosciences pour comprendre le cerveau humain. La différence : dans l’IA, chaque neurone artificiel est observable.

Des startups comme Goodfire développent des outils d’interprétation de l’IA, pour visualiser les raisonnements et guider les prises de décision des modèles. Cette course contre la montre vise à garantir la fiabilité des modèles d’IA avant qu’ils ne deviennent autonomes.

D’ici 2027, selon Amodei, nous pourrions disposer d’outils fiables pour détecter les intentions malveillantes et assurer la sécurité des IA. Une telle avancée offrirait un avantage stratégique aux acteurs capables de maîtriser l’IA générative, dans la compétition technologique entre les États-Unis et la Chine.

Le 15/05/2025

Source web par : leseco

www.darinfiane.com www.cans-akkanaitsidi.net www.chez-lahcen-maroc.com

Les tags en relation

Les articles en relation

CHATGPT : COMMENT L’UTILISER DANS LE MARKETING DIGITAL ?

Vous avez certainement entendu parler de ChatGPT, le dernier outil d’Intelligence Artificielle (IA) qui fait sensation. Mais savez-vous vraiment comment il fo...

MAI-DxO : l’IA de Microsoft bat les médecins en diagnostic

Microsoft explore une nouvelle frontière de l’intelligence artificielle en santé avec MAI-DxO, un système d’IA diagnostique avancé conçu pour assister ...

Enthousiasme et Appréhension : Les Consommateurs Face à l'Intelligence Artificielle selon une Étu

Une enquête récente menée par le Boston Consulting Group (BCG), leader en stratégie d’entreprise, révèle que 70% des consommateurs sont enthousiastes à...

Étudiants et ChatGPT : une étude du MIT alerte sur la baisse de la pensée critique

Une étude préliminaire du MIT relance le débat sur les effets cognitifs de l’intelligence artificielle générative, comme ChatGPT, dans l’enseignement s...

L’Italie bloque le robot conversationnel ChatGPT

Rome accuse notamment l’intelligence artificielle d’OpenAI de ne pas respecter la législation sur les données personnelles. Les autorités italiennes o...

Conférence Nvidia GTC 2025 : Jensen Huang face aux défis de l’IA et à la montée de DeepSeek

Le PDG de Nvidia, Jensen Huang, prendra la parole ce mardi lors de la conférence annuelle GTC, un événement majeur pour les développeurs et l’industrie de...

Impact de l'IA sur la Créativité au Maroc : Opportunités et Risques

Une étude récemment publiée dans la Revue internationale de la recherche scientifique explore les effets de l'Intelligence Artificielle (IA) sur les proc...

ChatGPT affirme que l’intelligence artificielle remplacera plus de 5 millions d’emplois juste au

ChatGPT semble être suffisamment intelligent pour reconnaître que l'intelligence artificielle (IA) représente une menace pour les moyens de subsistance d...

Les créateurs de ChatGPT dévoilent les 34 métiers qui ne seront jamais remplacés par l’IA

Depuis l’arrivée de ChatGPT, de nombreux travailleurs se demandent s’ils ne risquent pas de perdre leur emploi au profit de l’intelligence artificielle. ...

ChatGPT : un nouveau moteur de recherche concurrent de Google

ChatGPT, la plateforme d'intelligence artificielle (IA) générative la plus populaire, évolue et se positionne désormais en concurrent direct de Google. ...

Google lance Gemini, son nouveau modèle d'IA

Google va commencer mercredi à déployer Gemini, son nouveau modèle d'intelligence artificielle (IA) censé lui permettre de mieux rivaliser avec OpenAI (...

Intelligence artificielle, une science sans conscience?

Et si le retour d’un homme motivé par l’argent et non par le bien de l’humanité était un nouveau cas de «science sans conscience», aux conséquences ...

jeudi 15 mai 2025

jeudi 15 mai 2025 0

0

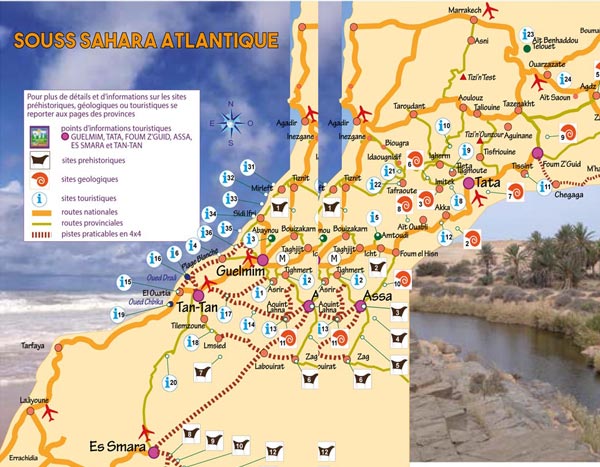

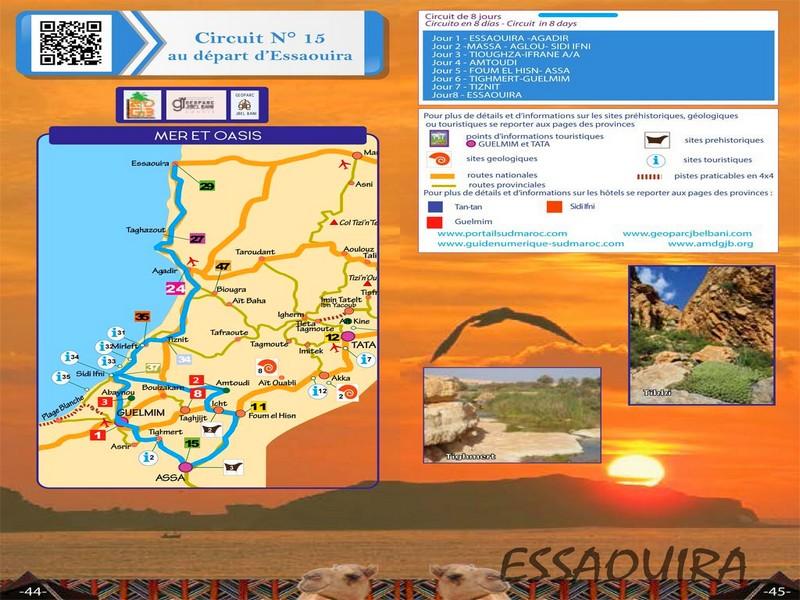

Découvrir notre région

Découvrir notre région