Christchurch: comment Facebook a été mis en échec

La vidéo du massacre de Christchurch a été diffusée largement sur Facebook en direct, passant outre ses systèmes de contrôle.

L'assassinat de cinquante personnes dans deux mosquées néo-zélandaises a pu être diffusé en direct sur Facebook. Le tueur avait préparé minutieusement son acte à des fins de propagande, recouvrant ses armes de références racistes, et installant son portable sur sa poitrine pour filmer ses crimes de plus près et les diffuser au plus vite.

Sa vidéo de 17 minutes a été vue par seulement 4.000 personnes avant d'être supprimée, assure Facebook, et aucun de ces spectateurs ne l'a immédiatement dénoncée. C'est seulement 29 minutes après le début de la diffusion, sur un signalement de la police néo-zélandaise, que la vidéo a été retirée, sans empêcher une très large rediffusion ensuite.

Mercredi, le vice-président de Facebook Guy Rosen s'est expliqué longuement sur son site en donnant des détails sur le fonctionnement de la modération sur la plateforme aux 2 milliards d'utilisateurs. Le site assure employer désormais 30.000 personnes pour la sécurité de la plateforme, dont 15.000 modérateurs.

"Nos systèmes d'intelligence artificielle s'entraînent avec des données, ce qui implique le traitement de milliers d'exemples pour détecter un certain type de texte, d'image ou de vidéo", a souligné Guy Rosen. "Cette méthode a très bien fonctionné pour la nudité, la propagande terroriste mais aussi la violence, quand on a de nombreux exemples. Cependant, cette vidéo en particulier n'a pas éveillé l'attention de nos systèmes de détection automatique".

Dans les 24 heures suivant l'attaque, Facebook explique avoir retiré 1,5 million de copies de la vidéo, dont une grande partie avant même leur publication.

"Nous aurons besoin de soumettre à nos systèmes des volumes importants de données de ce type de contenu, ce qui est difficile puisque ces évènements sont heureusement rares", poursuit Guy Rosen. "Un autre défi sera de différencier automatiquement ce type de vidéo d'autres contenus, qui lui ressemblent mais sont inoffensifs. Par exemple, si des milliers de captations de jeux vidéo en direct sont mises de côté automatiquement par nos systèmes, nos modérateurs pourraient rater des vidéos de la vraie vie, qui servent aux services de secours pour intervenir".

Facebook explique aussi avoir dû affronter une "communauté de militants mal intentionnés qui ont travaillé de concert pour télécharger des versions modifiées de cette vidéo, dans le but de tromper notre filtrage".

La diffusion de la vidéo a ensuite été accélérée par des internautes qui ont refilmé la vidéo sur leur écran avant de la diffuser, mais aussi par certains médias qui l'ont diffusée, comme des tabloïds britanniques, ou des leaders politiques comme le président turc Recep Tayyip Erdogan, qui utilisent la vidéo à des fins électorales.

Au total, Facebook a dénombré 800 versions de la vidéo macabre.

Le 22 Mars 2019

Source web : atlas info

Les tags en relation

Les articles en relation

Michel Serres : «Il faudrait trouver un avocat à la nature»

L’historien des sciences Michel Serres, 88 ans, accuse l’économie de détruire la planète. Serge Picard pour Le Parisien Week-End ...

Le silence du pape François sur l’attentat au Sri Lanka perpétré contre des catholiques

Disons que pour 290 morts (maintenant 359), on pouvait s’attendre à plus que 30 secondes de discours et que 220 caractères (tardifs) d’un tweet. Beaucoup ...

Crise turque: l’onde de choc gagne d'autres pays

La crise économique en Turquie, provoquée par les sanctions américaines, provoque une onde de choc au-delà des frontières du pays, estime capital.fr, le si...

samedi 23 mars 2019

samedi 23 mars 2019 0

0

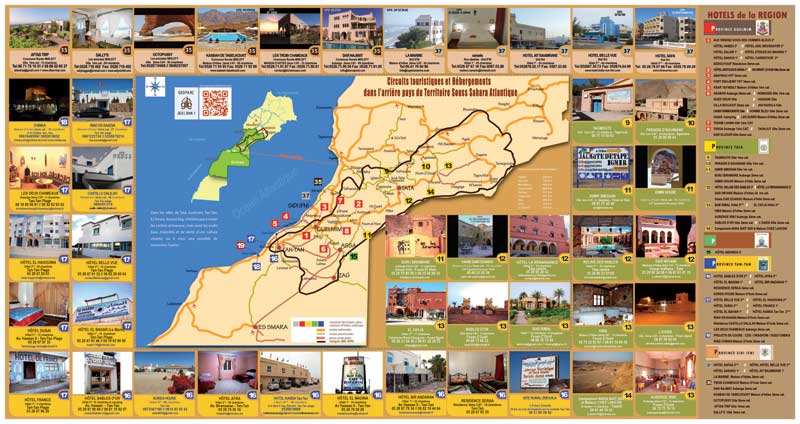

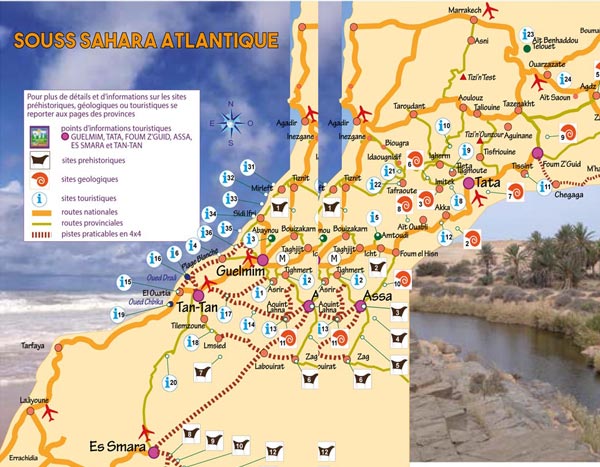

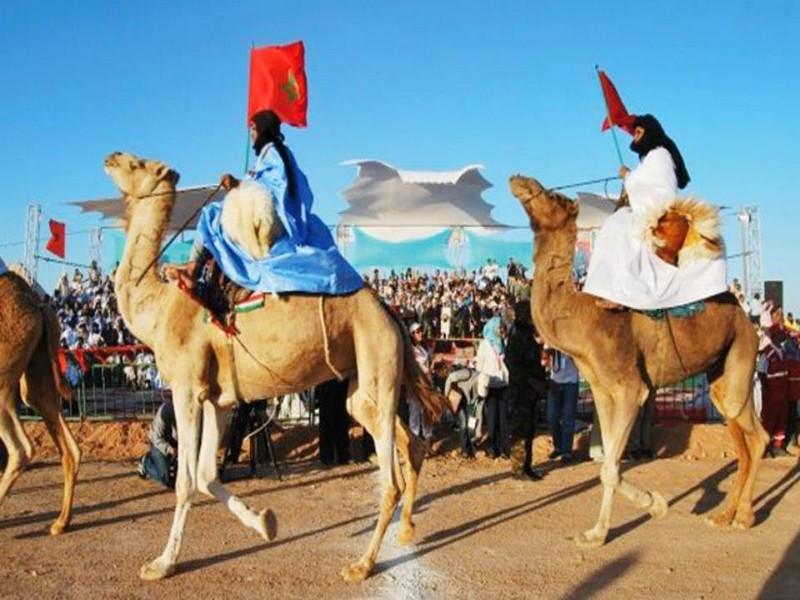

Découvrir notre région

Découvrir notre région